Google Glass体验

寝室里校园网居然可以直接上Google,所以Google Glass的全部功能都可以使用了!赶紧体验了一些功能。

Google搜索

Glass杀手级功能之一是Google搜索。抬头之后说“ok glass, Google…”就可以实现,很方便。搜索结果会优先从Knowledge Graph中找,找到的话会显示为卡片,然后朗读出摘要。不然会逐条列出结果。每一个结果都可以直接点进去查看网页,看是看得清,不过比较累。

knowledge Graph包括的内容范围已经相当大。我测试了一些条目都直接返回了Knowledge Graph中的内容。下面是几个例子:

Query: “Sword Art Online”

Query: “Sword Art Online”

Query: “What’s the weather?”

Query: “What’s the weather?”

直接询问一些简单的问题,比如天气、计算之类,都可以直接返回结果。这项功能实用度已经达到很高的地步,可以做到随时问随时答。英语朗读语音不错,感觉和Siri不相上下。如果网络覆盖良好,并且可以painless地上Google,那这个功能是逆天的存在。比如:

- 做线代时突然忘记正交矩阵的定义,可以一抬头,问”ok glass, Google what is an orthogonal matrix?” 然后坐等答案。

- 码代码时候突然忘记C++的string类有哪些方法了,就可以问”ok glass, Google C Plus Plus string class”。

- 出去玩很想了解一下某个建筑物的历史,可以问”ok glass, Google when was the Golden Gate Bridge built?“。

这个功能完全符合Google希望的,让信息可以被更方便地获取的目标。

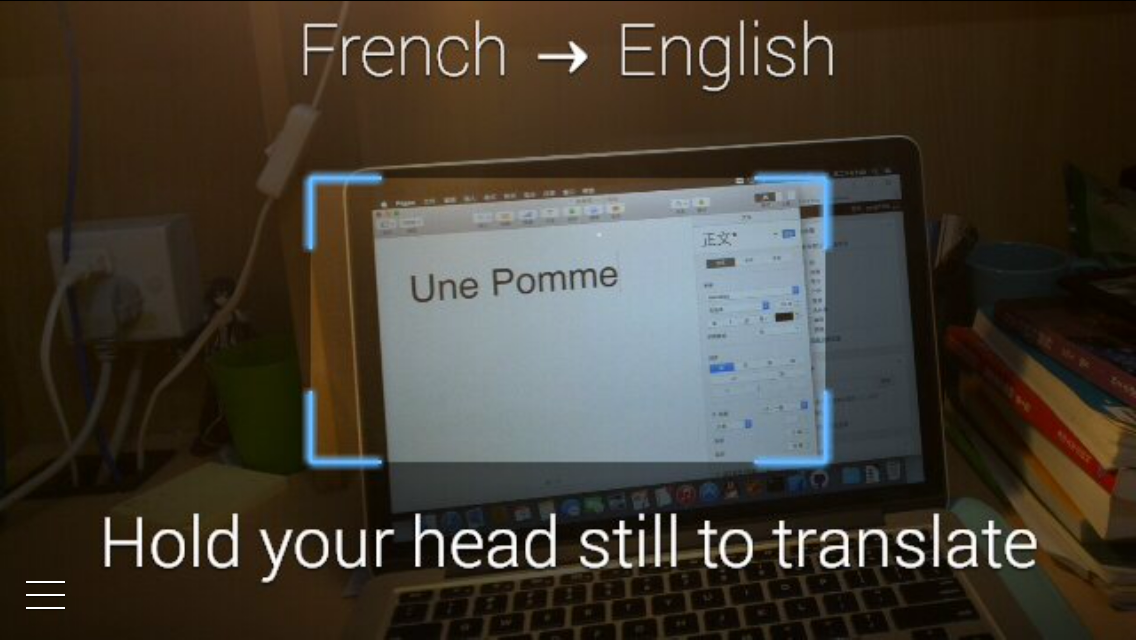

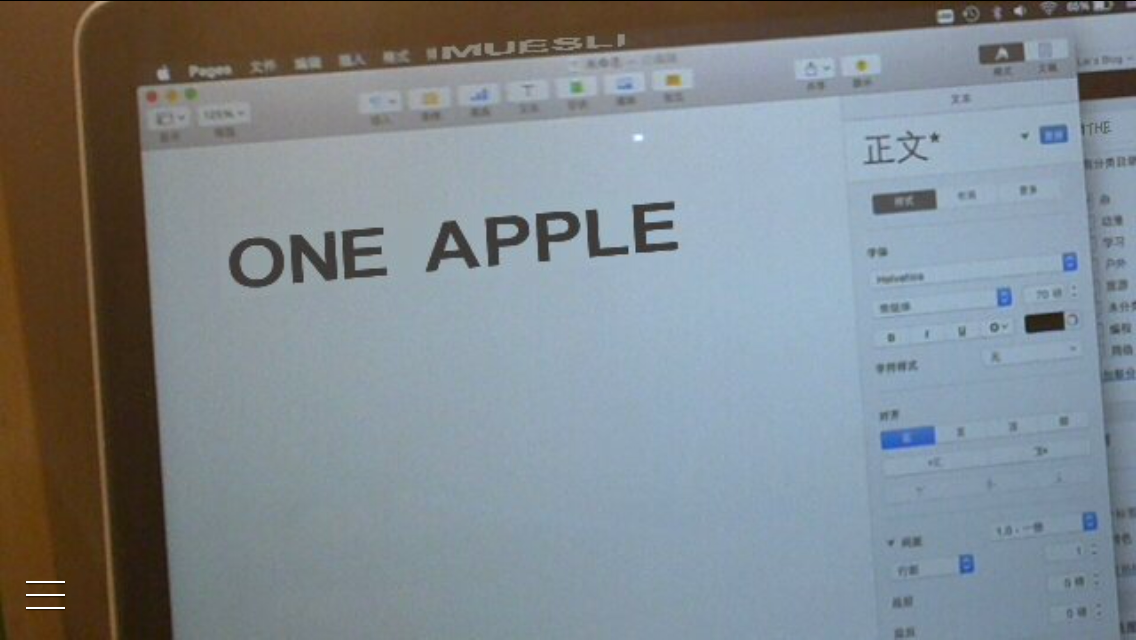

Word Lens

这个软件本来是iOS上的实时翻译软件,前段时间被Google收了去之后,App Store上就停止更新并且永久免费了,然后Glass上出现了这个Glassware。

“ok glass, translate this”

“ok glass, translate this”

将目光对准要翻译的内容

将目光对准要翻译的内容

目光稳定,Glass上已经显示出翻译后的画面了

目光稳定,Glass上已经显示出翻译后的画面了

无需网络连接,在旅游的时候用画面实在太美。只支持拼音文字的翻译,例如英语、法语、德语、西班牙语之类的互翻。很强大的功能。缺点是头不能乱动,要基本看着要翻译的东西才能成功识别。识别率是没问题的。

导航

导航的效果比较科幻,视野右上角有一张地图,是俯视视角的。导航支持驾车、公共交通、步行。不过一直没啥机会用,只有在学校边上买东西的时候玩过。在导航中可以通过ok glass语音控制,显示完整路线、退出导航之类的功能。

拍照

Glass基本上有三种触发拍照的方法:眨眼、语音控制、按钮。镜架上有专门的拍照按钮,短按拍照长按录像(录像非常耗电而且发热厉害)。眨眼的话是眨右眼(Glass的Wink Sensor在右侧),一般的眨眼是触发不了的,要闭上一会儿才能出发。打哈欠之类的也是触发不了的,要轻轻闭上。这个动作难度太高,我已经把这个功能关掉了。语音控制就是对着Glass说”ok glass, take a picture”,这样是不会出取景器,而是直接拍下来的。还可以说”ok glass, show the viewfinder”,这样会有取景器,取好景之后可以通过触控或语音来控制拍照或录像。

样张:做成Vignette的照片

样张:做成Vignette的照片

Google Now

这是Google寄予厚望的特性。在它几年前出现时,我猜测这是Google将来将会推向所有平台的功能。而今天,它已经占领了除了Windows Phone之外几乎所有平台——桌面和移动,穿戴式和传统计算设备。Glass的Slogan是”Live in the here and now”,这个梦想一部分得靠Google Now来实现。

Google Now通过学习用户的历史搜索记录、日历、邮件、常去地点等等,猜测用户正需要什么信息,然后显示在Glass的”Future”时间线上。现在可显示的信息有很多:上下班的时候显示通勤提示、有乘机信息时显示登机口和正晚点信息、每天晚上和早上显示天气、检测到出国时显示当地常用词汇等等。这个功能在国内用处还不是很大,而且就我而言,我目前的生活节奏就是:早上去二教,下午去理教,晚上回寝室码代码,Google很难学习到我的这个生活路线。所以,它现在推送的大都是天气、附近景点、股票(APPL…)之类。

Google Now卡片:附近景点

Google Now卡片:附近景点

而根据一些外国媒体的评价,Google Now是Glass上相当好的功能。用机器学习代替人力,为每个人提供个性化的服务,是一个很好的点子!

显示效果

应该有很多人好奇Google Glass的显示效果。把手机拿在手上,手臂伸直放在眼睛同一高度,这就是Glass显示器的实际成像效果。像是半透明的虚像,成在明视距离处,看起来并不累。分辨率方面无颗粒感。颜色方面偏淡。

UI

UI全面卡片化,每一个Glassware在运行时独占一个卡片,此外每一条通知都是一个卡片。在主界面(时间+”ok glass”)左侧是”Future”轴,右侧是”Past”轴,卡片按照时间顺序排列,越早的越远。在触控板上快速滑动,卡片也会快速滑动,不过这个时候会稍稍卡顿一下。整个操纵用得最多的是触控板。上下左右、单指双指都用上了。语音也是很强大的操纵,识别率极棒,比Siri好很多。大部分Glassware是需要”ok glass”加指令才能进入的。还有略科幻的交互,比如眼球追踪。应用是:有通知来时,发出提示音。这时如果瞥向显示屏,就点亮屏幕显示通知。眨眼拍照也算一个应用。

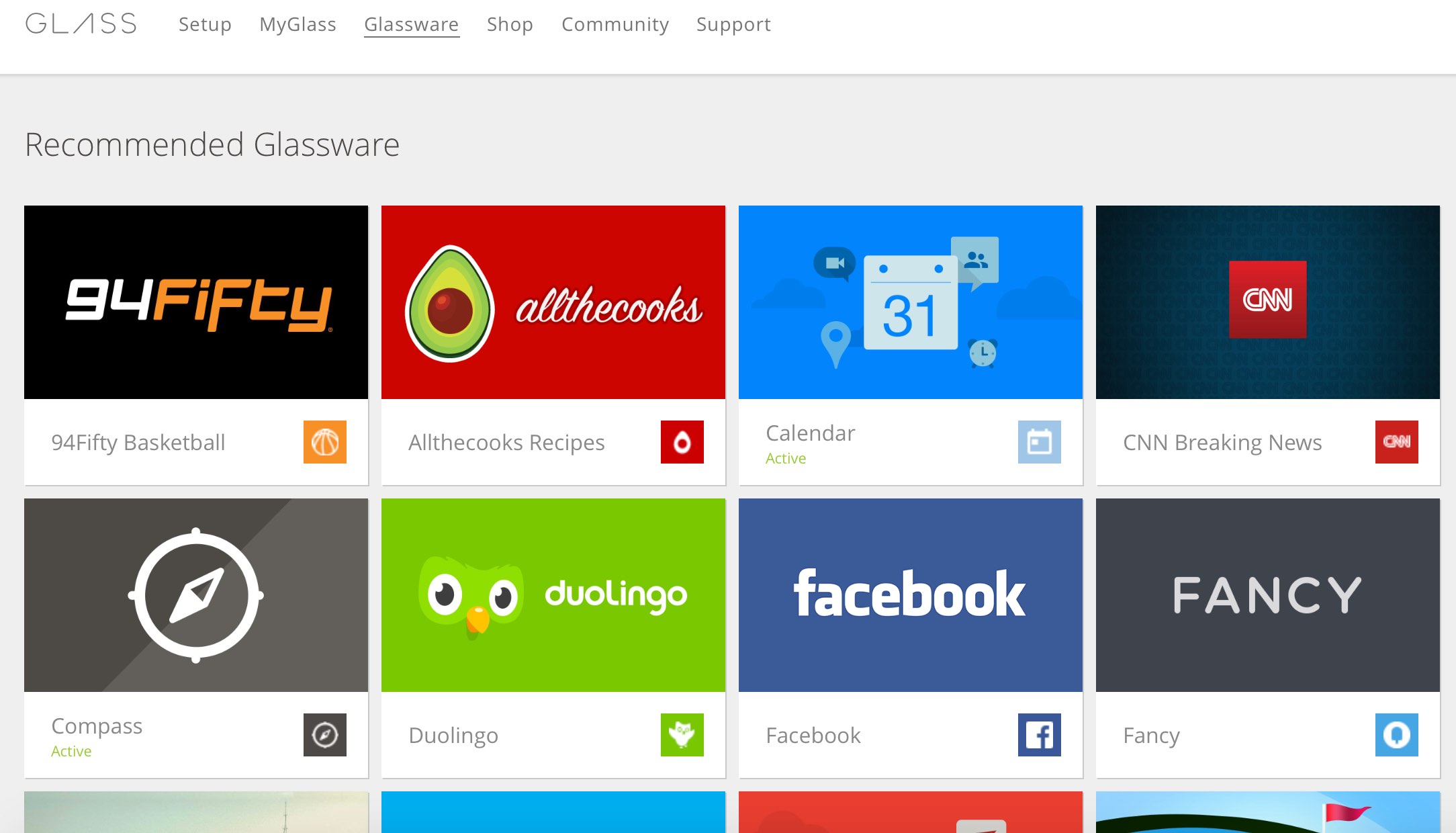

Glassware

现在有很多有创意的Glassware。上面提到的几个除外,还有一些比较神奇的,比如星图、测色计、判断音调和强度的软件、听音辨曲软件、字幕软件(把说的话转化为字幕,显示在对方Glass上,方便与听力障碍者交流)、演讲注释(显示演讲稿或提示词)等等。主要利用的,还是Glass提供的一块不用低头不用动手就能看到的显示屏。

一些Glassware

一些Glassware

有些Glassware虽然在智能手机上也有对应的实现,但是在Glass上使用有很不错的效果。除了前面讲过的Word Lens,下面列出一些:

- musiXmatch:不仅可以辨识音乐,还可以实时同步显示歌词。亲测识别能力超强,歌词库量大。

- Magnify:数字望远镜,放大效果还不错的。

- RedLaser:扫描商品条码,貌似是eBay的子公司出的。

- IFTTT:很著名,不多说。

- Color Detector:显示眼前颜色的HEX编码。

- Refresh:在和不是很熟悉的人交谈时,自动弹出关于对方的信息卡片,让交流更加顺畅。

- RTA for Glass:检测声音频率和强度。

- Star Map:增强现实,在视线右上角显示星图。和手机 / 平板上的类似软件功能相似,但是用起来比较轻松。

Google在Glass的开发者指南中说到了Glass的精髓:首先,它不是智能手机的替代品。它的目标是让人能够即时处理当前的信息。因此,Glassware应当遵守简单和轻量的原则。上面提到的那些基本上功能在于“扩展人的能力”,比如让人能够“看出”这个二维码的内容、“听出”当前播放的音乐,“拥有”超级视力,等等。

总之,不应该让Glassware去和智能手机的App去抢生意。我觉得比较好的方法是:在Glass上触发,然后如果需要比较大量的交互,就转到手机屏幕上,有点像Apple的今年大谈特谈的Continuity。在什么地方干什么事,我觉得这一点对App设计相当重要。我也在iPhone上装了SSH Clinet,但那注定是用来应急的。iPad上装了代码编辑器,但我肯定只会用来小修小改一下。同样地,要在Glass上实现文档编辑、大篇邮件编写、高强度网页浏览、视频播放,我觉得都是没有意义的。你的手机就在兜里呢,要干重活的时候就得拿出来用。手机不够还有平板电脑,再不够就坐下来拿出笔记本。在合适的平台做合适的事情,效率永远是最高的。

今年寒假打算用Mirror API开发一个Glassware,主要准备实现一些自己在学校用的功能,对,找自行车找教室找食堂什么的。

理解

Google设计Glass时,还有发布之后被采访时,多次提到这个设备的理念是让科技在人需要的时候出现,人不需要时自动隐去。虽然头上的一块棱镜+触控板还达不到“隐去”的效果,但相比手机而言,带来的分心时间明显短了很多。如果能够借着摩尔定律做到更小型,那甚至可以集成入隐形眼镜、普通框架眼镜之类的地方。目前的Google Glass重量已经很轻,再对比它的原型机,现在的Explorer Edition做的很好。

感觉目前的最大困难还是电池。Glass的续航最多6小时,这是在较低使用频率的条件下。虽然小电池充起来也快(1小时),但是还是希望能有12小时甚至24小时的续航,至少在白天不用主动关注是不是快没电了,要不然的话充电问题对人来说也是一个干扰源。

对于声音,Google的解决方案是骨传导。效果实在是太好了。比经常耳机拿上拿下要方便太多。对于需要高音质的场合,也有耳机可用(单声道 / 双声道)。

Google Glass的潜力很大,而且和它刚发布的时候相比,开发者们已经发掘出了它的一部分潜力。在使用它时,不能把它当作戴在头上的智能手机,而应该距离人最近的,最直观的,通向信息的一个通道。人们需要时,它可以随时提供帮助。它让我看到EE和CS这两门学科无限的想象力。